Jak zoptymalizować serwis pod LLM AI?

Pamiętam, jakim zaskoczeniem było dla mnie piętnaście lat temu, gdy zauważyłem, że ludzie przestali wpisywać w wyszukiwarkę same słowa kluczowe, jak robiło się to w branży IT. Zamiast pisać „drukarka HP {model} problem druk”, zaczęli wpisywać całe pytania, na przykład „dlaczego moja drukarka HP nie drukuje po wymianie tuszu?”. Teraz ta zmiana nabiera kolejnego znaczenia. Modele językowe nabierają tempa w wyszukiwaniu treści w internecie, dlatego dowiedz się jak zoptymalizować się pod LLM AI.

Co to jest LLM i jak wpływa na SEO?

AI odgrywa coraz większą rolę w tym, jak użytkownicy szukają informacji. LLM, czyli Large Language Model, to zaawansowany model językowy, który potrafi analizować i generować treści w sposób zbliżony do ludzkiego. Dla SEO to prawdziwa zmiana zasad gry. I to już się dzieje teraz.

Tradycyjnie optymalizowałeś stronę pod kątem wyszukiwarki – konkretnie Google. Zastanawiałeś się, jak robot indeksuje stronę, które frazy kluczowe działają, jak poprawić CTR w wynikach. Teraz pojawia się nowy gracz – LLM, który nie tylko przetwarza treść, ale też interpretuje znaczenie. Modele takie jak ChatGPT, Gemini, Claude czy Copilot nie przeszukują internetu w klasyczny sposób. One analizują dane, które już poznały, a następnie generują odpowiedzi oparte na kontekście, wiarygodności i strukturze informacji.

To oznacza jedno: nie walczysz już tylko o pozycję w Google, ale o widoczność w odpowiedziach generowanych przez AI. Kiedy ktoś zada pytanie w asystencie AI, to właśnie LLM decyduje, czy Twoja strona zostanie przywołana jako źródło. I tu mamy teraz nowy rodzaj SEO – optymalizacja pod modele językowe.

Taki LLM analizuje nie tylko słowa kluczowe, ale też relacje między pojęciami, strukturę tekstu, spójność logiczną i autorytet domeny. W tym przypadku nie liczy się tyle gęstość fraz tylko zabawa w znaczenie, intencję i kontekst. Jeśli Twoje treści są chaotyczne, przepisane z innych stron, bez unikalnej wartości – model AI je zignoruje. Jeśli natomiast opisujesz temat jasno, używasz precyzyjnych pojęć branżowych, a Twoje dane są aktualne – LLM potraktuje Cię jako wiarygodne źródło.

Widać też wyraźny trend: Google wykorzystuje AI Overviews, a Bing integruje Copilota. W praktyce użytkownik coraz rzadziej klika w wyniki organiczne. Zamiast tego otrzymuje gotową, syntetyczną odpowiedź. To że przełoży się to w przyszłości na mniejszy ruch organiczny to inna historia – teraz musisz zadbać o to żeby być tam widocznym. Jeśli więc Twoja strona nie jest przygotowana na analizę przez modele językowe, możesz zniknąć z pola widzenia użytkowników, mimo że formalnie nadal jesteś wysoko w rankingu.

Skuteczne metody – techniczne SEO dla LLM

Modele językowe analizują teraz strony głębiej niż klasyczne roboty wyszukiwarek. Widzą nie tylko słowa, ale też strukturę, relacje i sposób, w jaki serwis komunikuje dane. Jeśli chcesz, żeby Twoja strona była dla nich czytelna, musisz zadbać o techniczne SEO. Przytoczę tu kilka skutecznych metod.

Na początek struktura strony. Hierarchia nagłówków powinna być logiczna – jedno H1, potem H2 i H3, bez chaosu. Gdzieś to już czytałeś, nie? To klasyczna zasada SEO, która w erze AI wciąż ma znaczenie. Ale jest coś jeszcze. Ciekawostka: niedawno naukowcy analizowali 26 języków narodowych, sprawdzając, który z nich jest najłatwiejszy do przetwarzania dla modeli AI. Wygrał język polski. Dlaczego? Bo jest logiczny, ma jasno określone reguły gramatyczne i wymaga mniej kontekstu, by zachować sens. To dokładnie ten sam powód, dla którego przejrzysta struktura strony pomaga AI szybciej zrozumieć Twoje treści. LLM AI po prostu nie cierpi bałaganu bo ten pożera jego zasoby.

- hierarchia nagłówków H1 – H6

- logiczna i płytka struktura strony, z czytelną nawigacją w HTML,

- maksymalna szybkość ładowania i zoptymalizowane zasoby, AI nie będzie czekać

- czysty kod HTML bez kluczowych treści ukrytych za JavaScriptem

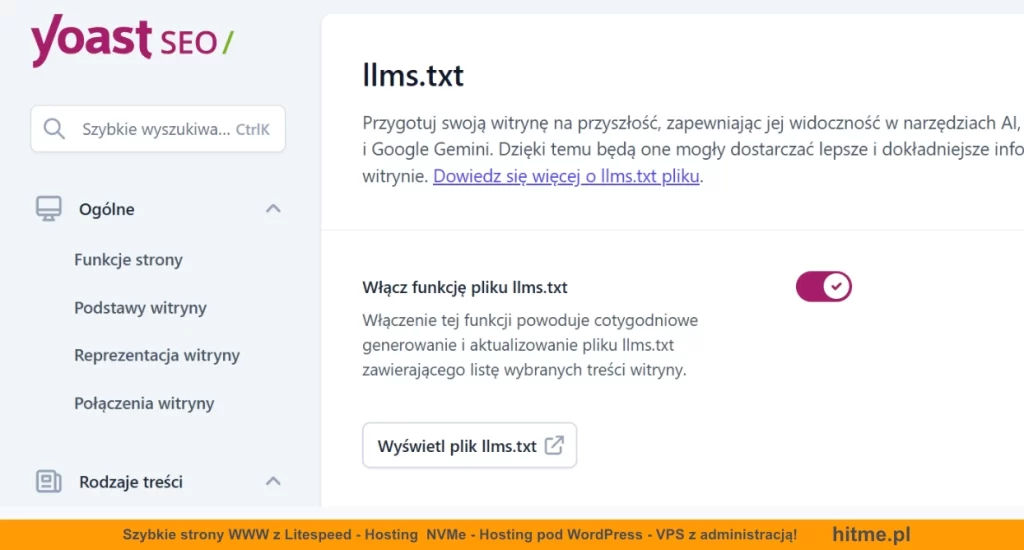

Pliki konfiguracyjne robots.txt i llms.txt

robots.txt nadal pełni funkcję bramkarza dla crawlerów. Upewnij się, że nie blokujesz zasobów, które LLM powinien widzieć. Swojego czasu, jakaś wtyczka mogła nawet zablokować wykorzystanie Twoich źródeł danych do trenowania.

Przykład blokowania w robots.txt:

# Blokada popularnych botów LLM / źródeł danych do trenowania User-agent: GPTBot # OpenAI Disallow: / User-agent: Google-Extended # kontrola użycia do trenowania / grounding Gemini Disallow: / User-agent: Applebot-Extended # kontrola użycia przez Apple do trenowania Disallow: / User-agent: CCBot # Common Crawl (często źródło danych dla LLM) Disallow: / User-agent: PerplexityBot # Perplexity AI crawler Disallow: /

Z kolej plik llms.txt to najnowszy standard, którym kontrolujesz, jak modele językowe (np. ChatGPT, Perplexity, Gemini) mogą korzystać z Twoich treści. Umieszczasz go w tym samym miejscu, w głównym katalogu strony. Możesz tam określić, które katalogi są dostępne do analizy, a które nie. To narzędzie ochrony, ale też komunikacji – dajesz AI jasny sygnał, że Twoje dane są gotowe do wykorzystania.

Metadane, dane strukturalne

Do tego dochodzą metadane, schema.org i JSON-LD. Modele językowe interpretują te dane jako wiarygodne źródło kontekstu. Oznacz autora, datę, typ treści, produkty, recenzje czy FAQ. Szczególnie dobrze działają schematy FAQPage, HowTo, Product i Organization. Dzięki nim AI lepiej rozumie, kim jesteś i jaką wiedzę reprezentujesz. Wspominałem już o tym w artykule Semantyczne SEO – na czym polega? Ale dla przypomnienia, co oznaczają te pojęcia?

- Schema.org to zestaw standardów, które opisują, czym jest dana treść – np. artykuł, produkt czy sekcja FAQ.

- JSON-LD to sposób, w jaki ten opis wprowadzasz do kodu strony. To fragment skryptu

<script type="application/ld+json">, który mówi wyszukiwarce i AI: „to jest pytanie, a to odpowiedź”. - Mikrodane (czyli atrybuty

itempropw HTML) to starsza metoda – działa, ale trudniejsza w utrzymaniu. Google i modele językowe preferują dziś JSON-LD.

Jak napisać treści, które LLM rozumie najlepiej?

Pisz tak, jak użytkownik pyta. Krótko, jasno i od razu do sedna. Zacznij od odpowiedzi, a dopiero potem dodaj kontekst. LLM preferuje strukturę „answer-first”, bo łatwo z niej cytować fragmenty. Jeśli temat jest szeroki, rozbij go na sekcje z wyraźnymi śródtytułami – każda powinna odpowiadać na jedno pytanie.

Unikaj nadużywania słów kluczowych. LLM nie liczy fraz jak stary algorytm Google, tylko analizuje znaczenie. Lepiej działa naturalny język i bogactwo słownictwa. Zamiast powtarzać w kółko „optymalizacja pod LLM”, używaj wariantów: „SEO dla AI”, „przygotowanie treści dla modeli językowych” czy „pozycjonowanie w erze sztucznej inteligencji”. Dla modelu to wszystko ten sam temat, ale Twój tekst brzmi przyjaźniej i bardziej autentycznie.

Wykorzystuj synonimy i różne formy zapisu. Modele językowe rozumieją, że „strona”, „serwis” i „witryna” to to samo. Dzięki temu nie tracisz kontekstu, a tekst jest przyjemniejszy w odbiorze. Pisząc w ten sposób, jednocześnie trafiasz w różne zapytania użytkowników – od prostych pytań po złożone frazy konwersacyjne.

Pisz konkretnie. Jeśli coś opisujesz, dodaj dane, liczby lub przykład. Zamiast „strona ładuje się szybciej”, napisz „czas ładowania spadł z 2,8 do 1,4 sekundy po optymalizacji obrazów”. Takie informacje LLM potrafi cytować bez przekręceń.

AI wybiera fragmenty, które odpowiadają dokładnie na pytania użytkowników. Dlatego kluczowe jest, żeby Twój tekst miał jasną strukturę, logiczne nagłówki i krótkie, konkretne akapity. Modele szukają zdań w stylu „X to…” albo „A oznacza, że…”. Każdy akapit powinien mieć sens sam w sobie, jak mały blok wiedzy gotowy do zacytowania.

Jak znaleźć się w AI Overview?

AI Overview to dziś nowa forma wyników wyszukiwania – nie jest listą linków, ale gotowymi streszczeniami odpowiedzi. Google nie wybiera już stron po gęstości fraz, tylko po jakości informacji. Model Gemini analizuje nie tylko treść, ale też intencję i przejrzystość przekazu. Twoim celem nie jest już „ranking”, ale cytat – fragment, który AI uzna za najtrafniejszy i najbezpieczniejszy do przytoczenia.

Żeby zwiększyć szansę, że Twoja treść pojawi się w AI Overview, musisz pisać w sposób, który ułatwia modelowi ocenę sensu, precyzji i wiarygodności. Pamiętaj, nie chodzi o algorytmy SEO, tylko o klarowność komunikatu.

Zastosuj te zasady, jeśli chcesz, żeby Twoje teksty zyskały szansę na pojawienie się w AI Overview:

- Skup się na intencji, nie frazie. Odpowiadaj na to, co użytkownik naprawdę chce wiedzieć

- Buduj kontekst tematyczny. Model analizuje relacje między tekstami. Linkuj wewnętrznie między powiązanymi treściami i stosuj logiczne powiązania semantyczne.

- Zadbaj o spójny ton i narrację. Treści pisane równym stylem i językiem branżowym są dla modeli bardziej wiarygodne.

- Dodaj warstwę wiarygodności. AI ocenia autorytet strony – pomóż mu, pokazując autora, źródła danych, referencje i daty aktualizacji.

- Stosuj dane porównawcze i przykłady. AI lubi treści, które zawierają porównania, zestawienia i wnioski.

- Zachowaj precyzję języka. Unikaj uogólnień, marketingowych frazesów i emocjonalnych przymiotników.

- Dbaj o aktualność i kontekst czasowy. W AI Overview pojawiają się źródła, które są świeże lub jasno oznaczone datą.

Nie znalazłem żeby np. Google gdzieś publikowało pełną listę kryteriów AI Overview. Ale jest jakiś widoczny wzorzec: że AI wybiera treści, które są rzetelne, precyzyjne i możliwe do zacytowania bez zmiany znaczenia. Nie musisz pisać pod algorytm – wystarczy pisać jak ekspert, który wyjaśnia trudne rzeczy w prosty sposób.

FAQ – przydatny element dla AI

Dla ludzi sekcja FAQ to szybka pomoc, a dla modeli językowych to mapa logiki. LLM nie widzi przycisków ani designu. Widzi pytania i odpowiedzi, które pomagają mu zrozumieć, co naprawdę robisz i w jakim kontekście. Dobrze zbudowane FAQ działa więc jak most między Twoim contentem a sztuczną inteligencją, która uczy się, jak o Tobie mówić.

Jeśli chcesz, żeby Twoje FAQ faktycznie działało w kontekście LLM i AI Overview, zadbaj o kilka rzeczy:

- Używaj prawdziwych pytań. Nie twórz ich pod SEO, tylko na podstawie realnych zapytań użytkowników – z forów, supportu czy czatu.

- Odpowiadaj jednoznacznie. Każde pytanie powinno mieć odpowiedź, która ma sens nawet poza kontekstem strony. Model często cytuje pojedyncze akapity, więc pisz tak, jakby tekst miał funkcjonować samodzielnie.

- Zadbaj o strukturę danych. Oznacz sekcję za pomocą

FAQPage, stosuj JSON-LD. To prosty sygnał, że dana treść jest pytaniem i odpowiedzią. Dzięki temu Google i inne modele rozpoznają ją natychmiast. - Twórz logiczne grupy pytań. Jeśli masz różne kategorie usług, zrób osobne bloki FAQ. LLM nie lubi chaosu – im bardziej spójny zestaw, tym większa szansa, że wykorzysta Twoje odpowiedzi.

- Stosuj język użytkownika. Pisz tak, jak ludzie naprawdę pytają. Zamiast „Jak zoptymalizować strukturę witryny?”, użyj „Jak poprawić budowę strony, żeby była lepiej widoczna w Google?”. AI to wychwytuje, bo odzwierciedla sposób, w jaki użytkownicy formułują zapytania.

- Aktualizuj odpowiedzi. Zmieniasz proces, cennik albo technologię? Zaktualizuj FAQ. AI nie lubi przestarzałych informacji – w podsumowaniach wybiera źródła, które wyglądają na świeże i spójne.

- Dodaj kontekst marki. Możesz subtelnie wpleść nazwę firmy, usługi lub branży w odpowiedzi. Dla AI to wskazówka, że jesteś ekspertem w danej dziedzinie, a nie ogólnym blogiem.

Warto aby FAQ na Twojej stronie wyrażał się również w postaci JSON-LD:

<script type="application/ld+json">

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "Czy JSON-LD pomaga w AI Overview?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Tak. Ułatwia AI i Google rozpoznanie typu treści, dat i autora, co zwiększa szanse na cytat."

}

},

{

"@type": "Question",

"name": "Które schematy wdrożyć najpierw?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Article/BlogPosting dla artykułów, FAQPage dla pytań i odpowiedzi, Organization dla danych o marce."

}

}

]

}

</script>Optymalizacja pod LLM a klasyczne SEO

Klasyczne SEO to walka o kliknięcie, a optymalizacja pod LLM to walka o zaufanie. W klasycznym SEO liczyły się frazy, crawl budget, meta tagi, linki zwrotne. Dziś znaczenie ma sens, kontekst i wiarygodność.

LLM nie analizuje słów jak robot Googlebot. On rozumie treść. Patrzy, kto ją napisał, czy brzmi logicznie i czy można jej zaufać. Nadal potrzebujesz szybkiej strony i poprawnych tagów, ale to tylko baza. W nowym SEO liczy się czytelność i naturalny język. Nie powtarzaj słów kluczowych – pisz tak, by człowiek i AI zrozumieli Cię bez wysiłku. Modele lepiej reagują na tekst, który brzmi jak rozmowa, nie jak optymalizacja. Zamiast budować linki, buduj kontekst. Łącz artykuły, FAQ i poradniki w spójną sieć tematów. Dla AI to znak, że naprawdę znasz się na tym, o czym piszesz. Klasyczne SEO uczy, jak być widocznym. Optymalizacja pod LLM – jak być zrozumianym.

W klasycznym SEO optymalizujesz pod algorytm, w LLM SEO – dla inteligencji. Model AI nie potrzebuje perfekcyjnego keyworda. Potrzebuje tekstu, który ma sens i wartość dla człowieka. Paradoksalnie – im piszesz bardziej po ludzku, tym lepiej zrozumie Cię LLM.

Nie. To jego rozwinięcie. Klasyczne SEO dba o technikę i strukturę, a optymalizacja pod LLM skupia się na znaczeniu, kontekście i wiarygodności treści. Oba podejścia muszą działać razem.

Tak, ale nie tak jak przeglądarka. Model językowy analizuje tekst, jego strukturę i relacje między pojęciami. Nie widzi wyglądu strony, tylko czysty kod HTML i dane semantyczne.

Nie musisz, ale warto. LLM lepiej rozumie treści, które są logiczne, proste i precyzyjne. Jeśli piszesz jasno i używasz naturalnego języka, optymalizujesz się pod AI automatycznie.

To nowy plik podobny do robots.txt, który określa, jak modele językowe mogą korzystać z Twoich treści. Możesz nim zablokować trenowanie modeli lub wskazać, które sekcje są dostępne do analizy.

JSON-LD. Jest czysty, stabilny i nie zależy od struktury HTML. LLM i Google preferują ten format.